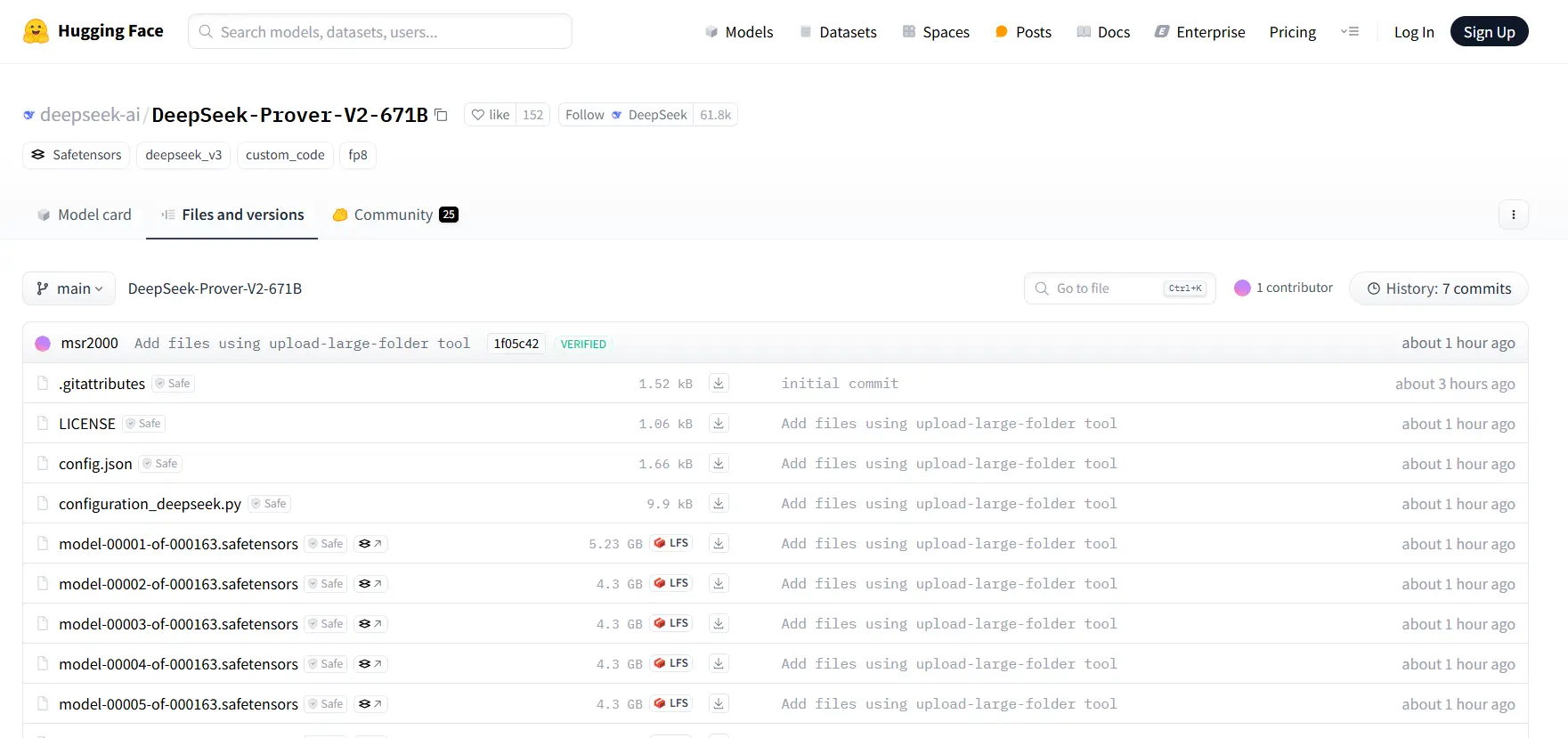

DeepSeek 在官方 Hugging face 库上低调开源发布了其最新开源模型 DeepSeek-Prover-V2-671B。一个专注于数学定理证明的大语言模型,专门针对形式化数学证明任务进行优化。

新模型具有以下特点:

- 模型规模巨大:参数量约为671B(6710亿参数),这从模型分片数量(163个)和每个分片大小(约4.3GB)可以看出

- 使用了DeepSeek-V3的架构:采用MoE(混合专家)模式,具有61层Transformer层,7168维隐藏层

- 专为数学定理证明优化:从名称"Prover"(证明者)可以看出,这是一个专注于数学推理和定理证明的专业模型

- 支持超长上下文:最大位置嵌入达163840,使其能处理复杂的数学证明

- 采用FP8量化:通过量化技术减小模型大小,提高推理效率