阿里通义实验室发布并开源了 MaskSearch 预训练框架,声称能让 AI 学会“主动搜索 + 多步推理”,从而更准确、更智能地回答复杂问题。

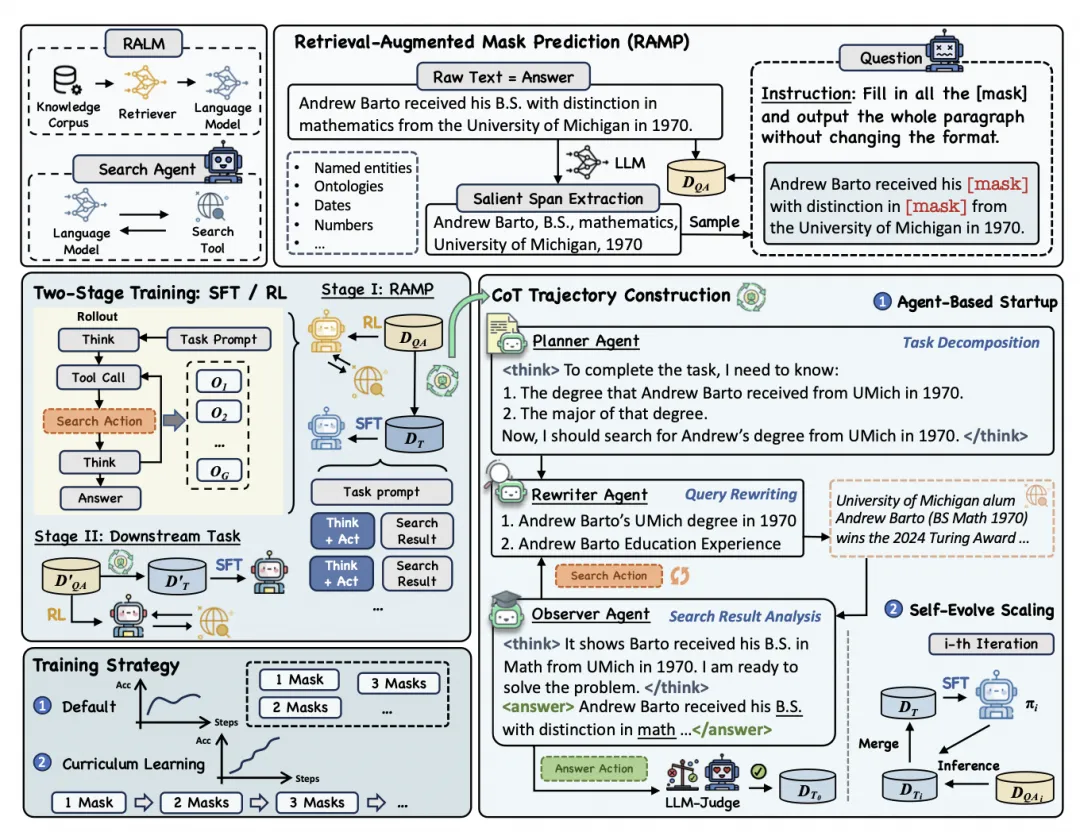

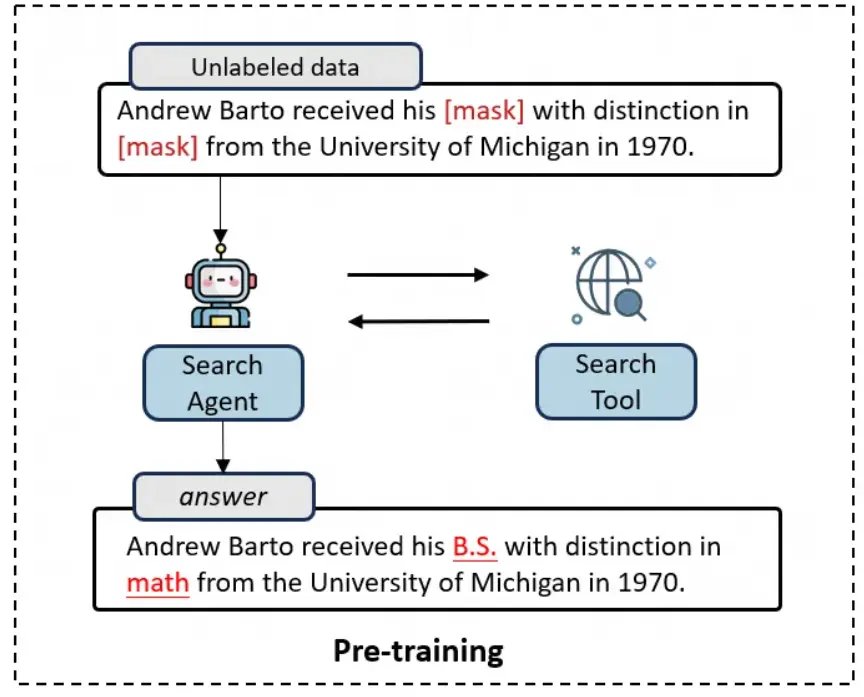

根据介绍,MaskSearch 的核心在于它提出的一种全新预训练任务——检索增强掩码预测(RAMP) ,在这个任务中,模型需要填补句子中的掩码部分,并且必须通过主动搜索和多步推理来完成任务。

例如,给定一个句子:

Andrew Barto received his [mask] with distinction in [mask] from the University of Michigan in 1970.

AI 需要通过搜索引擎查找相关信息,逐步推理出被遮盖的部分。模型首先分析上下文,判断需要查找的信息是“学位类型”和“专业方向”。随后,它调用搜索引擎进行查询,得到关于 Andrew Barto 的相关信息,并从中提取出关键片段:“Andrew Barto, B.S., math, University of Michigan, 1970”。

接着,AI 进行推理整合,最终填补掩码输出完整句子:

Andrew Barto received his B.S. with distinction in math from the University of Michigan in 1970。

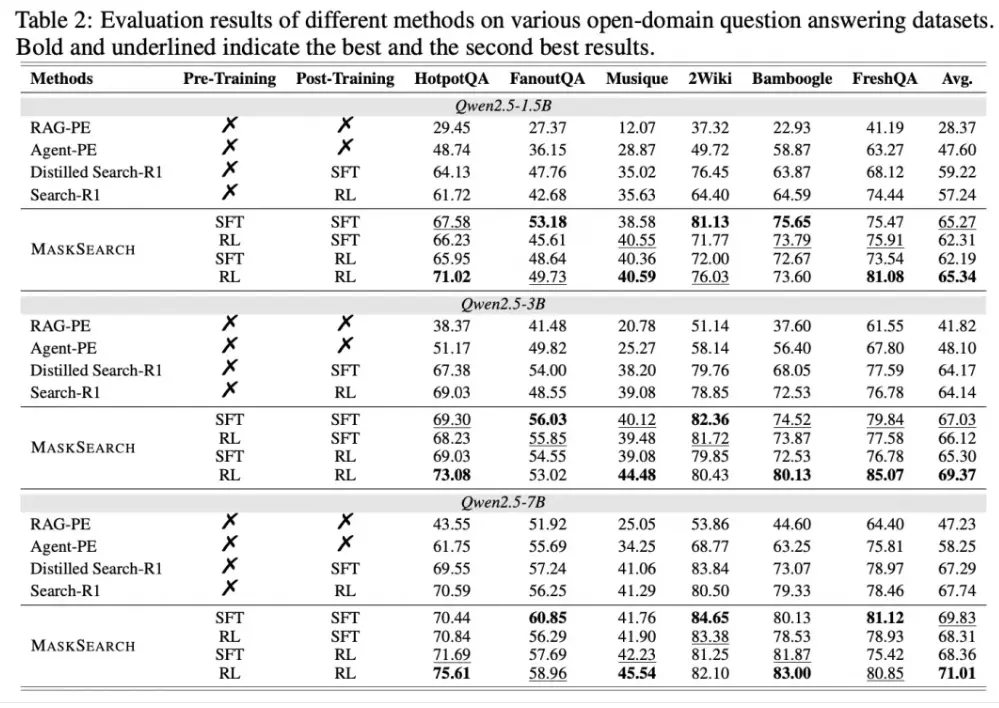

实验表明,即使是小模型(如 Qwen2.5-1.5B),在经过 MaskSearch 预训练后,也能在多个开放域问答任务中取得显著提升。例如,在 Bamboogle 数据集中性能提升超过 11.78% ,真正做到了“小模型也能挑战大模型”。