Ollama 最新版本已支持 RWKV7-G1 和 RWKV-7-World 系列模型。

3 月初,随着 RWKV 社区成员 @MollySophia 的 PR 被合并,llama.cpp 正式支持 RWKV-7 模型。Ollama 近期更新了最新版 llama.cpp,因此同步支持 RWKV-7 架构和对应模型。

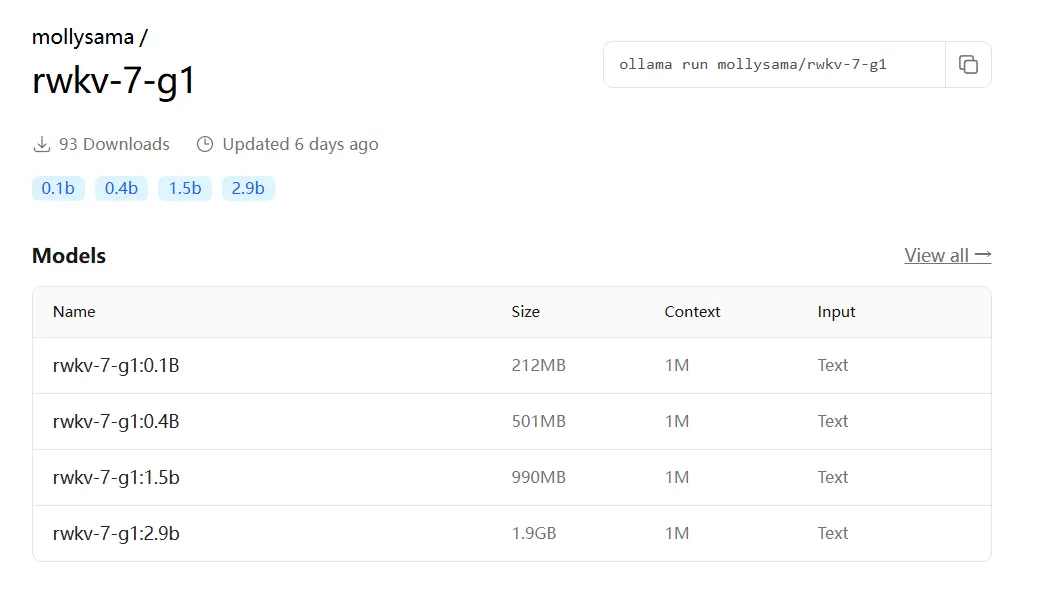

Ollama 官方模型仓库现已包含 RWKV-7 系列模型(推荐使用 RWKV7-G1 系列模型):

- RWKV-G1:https://ollama.com/mollysama/rwkv-7-g1

- RWKV-7-World:https://ollama.com/mollysama/rwkv-7-world

在 Ollama 中运行 RWKV 模型

以下是在 Ollama 中体验 RWKV-7 G1 2.9B 模型的最简路径。

- 在 https://ollama.com/download 页面,根据您的系统下载 Ollama 安装包:

- 下载完毕后,双击安装包以安装 Ollama。任务栏出现 Ollama 图标时,意味着安装已完成:

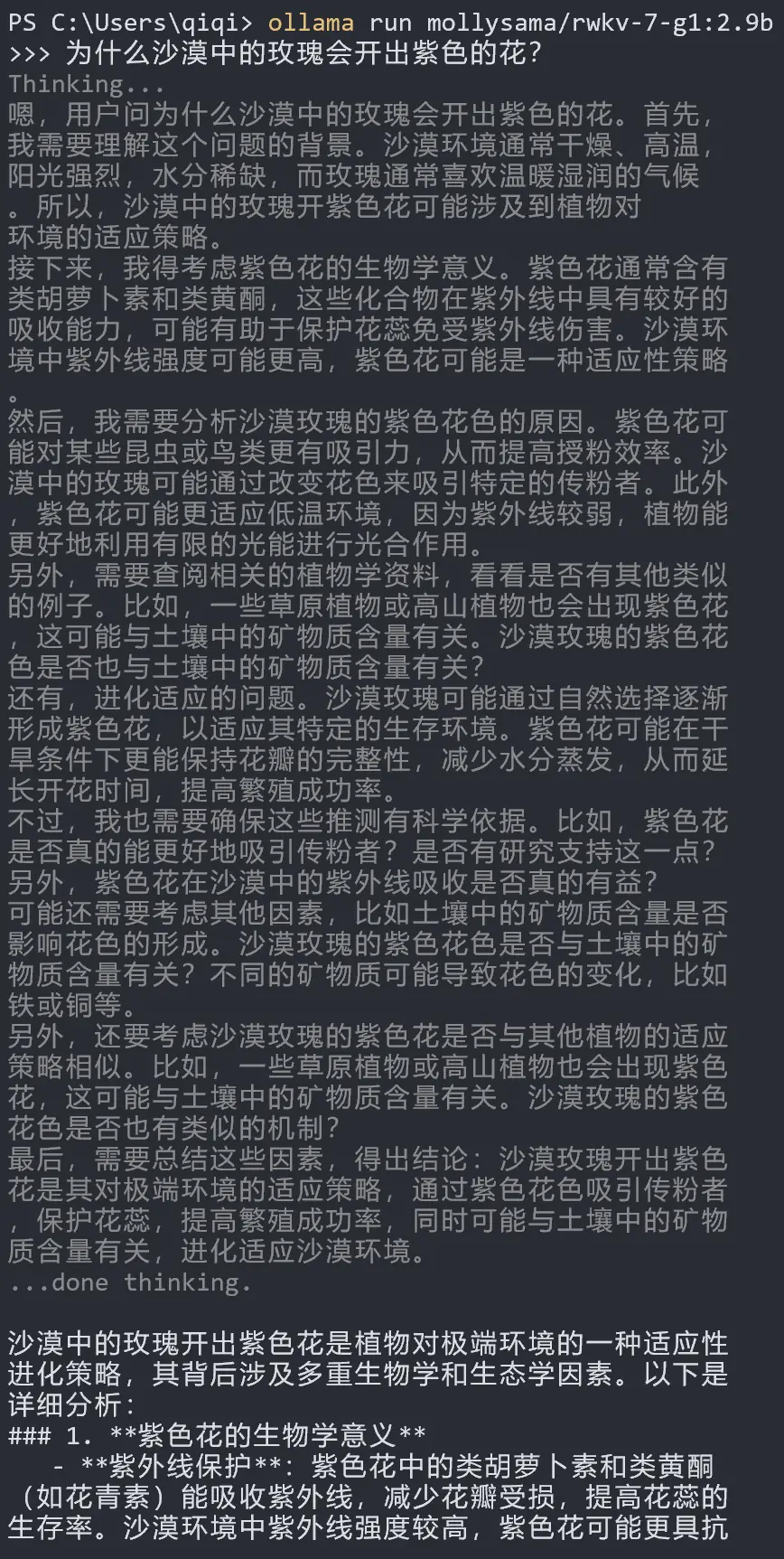

- 在终端中运行

ollama run mollysama/rwkv-7-g1:2.9b命令,Ollama 将自动下载并运行 RWKV7-G1 2.9B 模型。您可以在终端中与 RWKV 模型进行对话,如下图所示:

若您曾经下载过

mollysama/rwkv-7-g1:2.9b模型,请运行ollama pull mollysama/rwkv-7-g1:2.9b命令,拉取最新的变更。

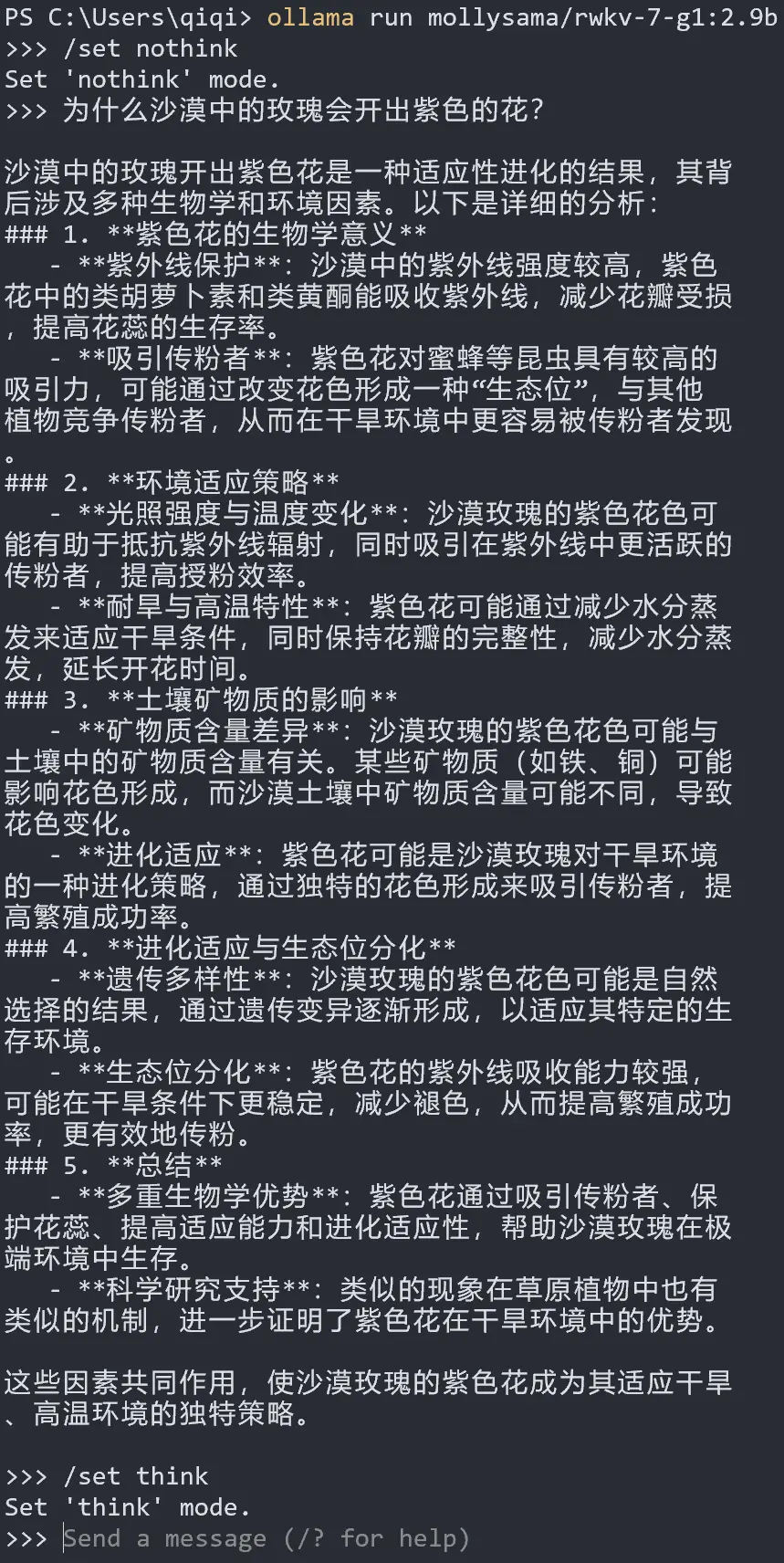

- Ollama 的 RWKV7 G1 模型默认开启思考模式,可以通过

/set nothink和/set think命令灵活地开关思考模式:

- 使用

ollama stop mollysama/rwkv-7-g1:2.9b命令可以停止当前模型实例,从而重置对话上下文,否则 Ollama 会**持续保留当前会话的上下文(历史消息)**作为后续对话的参考

Ollama 官方仓库提供

Q6_K量化的 RWKV7 G1 模型。如需使用其他量化类型,需手动创建自定义 RWKV 模型 ,详细教程请在 RWKV 教程 - Ollama 推理 中查看。

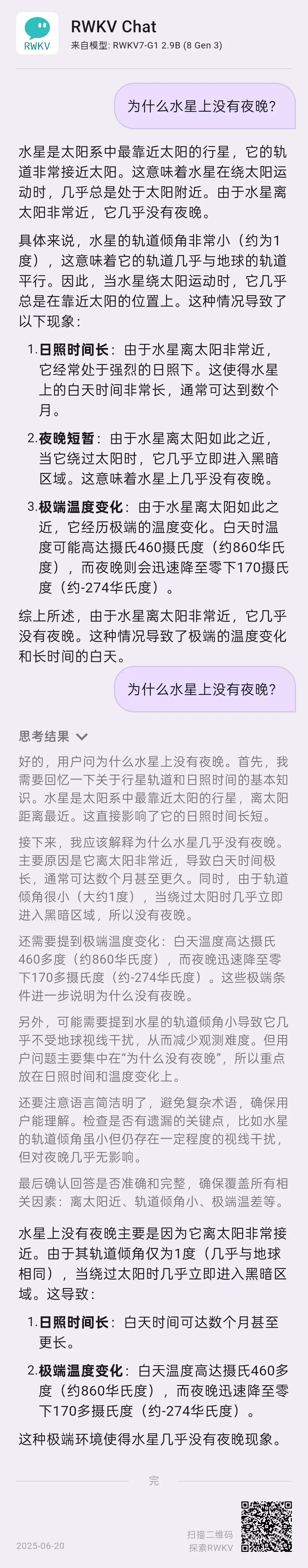

RWKV Chat 端侧聊天助手

除了在 Ollama 中运行 RWKV 模型,我们也推荐使用 RWKV Chat 端侧聊天助手体验 RWKV 模型。

RWKV Chat 是 RWKV 官方推出的离线 AI 聊天应用,针对各类端侧设备进行深度推理优化。APP 内含多种小参数模型,支持会话配置调整、灵活切换思考模式,是你的高效生产力伙伴!

在开启和关闭思考模式两种情况下,RWKV Chat 回答同一个问题:

- 下载 RWKV Chat APP:https://rwkvos.com/rwkv-chat

加入 RWKV 社区

欢迎大家加入 RWKV 社区,可以从 RWKV 中文官网了解 RWKV 模型,也可以加入 RWKV 论坛、QQ 频道和 QQ 群聊,一起探讨 RWKV 模型。

- 📖 RWKV 中文文档:https://www.rwkv.cn

- 💬 RWKV 论坛:https://community.rwkv.cn/

- 🐧 QQ 频道:https://pd.qq.com/s/9n21eravc

- 📺 BiliBili 视频教程:https://space.bilibili.com/3546689096910933